AI 혁신의 중심, AWS re:Invent 2025 키노트 핵심 요약!

전체 요약

AWS CEO Matt Garman이 발표한 2025 re:Invent 키노트는 AI 에이전트 시대의 본격적인 도래를 선언하며, AWS가 인프라부터 애플리케이션까지 전 계층에서 혁신을 이루고 있음을 보여줍니다. AWS는 연간 $132B 규모로 성장하며 20% YoY 성장을 기록했고, AI 인프라에서 Trainium 3 Ultra 서버와 Nova 2 모델 패밀리를 발표했습니다. 특히 Amazon Nova Forge를 통한 오픈 트레이닝 모델 개념과 Bedrock Agent Core의 Policy 및 Evaluations 기능을 소개하며, Kiro Autonomous Agent, AWS Security Agent, AWS DevOps Agent 등 3개의 Frontier Agent를 공개했습니다. 이는 개발자들이 AI를 활용해 10배 이상의 생산성 향상을 달성할 수 있는 새로운 시대를 열었습니다.

1. AWS, 대체 얼마나 크게 성장한 건가요?

AWS의 성장은 놀랍습니다. AWS는 이제 무려 1,320억 달러 규모의 거대 기업으로 성장했습니다 . 지난 1년 동안 20%의 연간 성장을 기록했습니다 .

이 성장의 규모는 더욱 대단합니다. 작년 한 해 동안 AWS가 성장한 금액만 약 220억 달러에 달합니다 . 이 금액은 포춘 500대 기업 중 절반 이상의 연 매출보다도 큰 수치입니다 . AWS의 서비스 역시 함께 엄청나게 성장하고 있습니다. 예를 들어, S3에는 고객들이 500조 개 이상의 객체를 저장하고 있으며 , 매일 평균적으로 초당 2억 건 이상의 요청이 들어오고 있습니다 . 또한, AWS 클라우드에 추가된 CPU 용량의 절반 이상이 그라비톤(Graviton) 칩에서 나오고 있습니다 . 데이터베이스 서비스는 이미 수백만 명의 고객이 사용하고 있습니다 .

AWS는 이처럼 압도적인 인프라를 바탕으로 AI 시대의 혁신을 이끌고 있습니다 . 전 세계 어디에도 AWS만큼 크고 폭넓게 배포된 AI 클라우드 인프라는 없다고 할 수 있습니다 . AWS의 글로벌 데이터 센터 네트워크는 38개 리전과 120개 가용 영역에 걸쳐있으며, 추가로 3개 리전을 더 만들 계획입니다 . 지난 1년 동안 AWS가 추가한 데이터 센터 용량은 3.8기가와트로, 이는 전 세계에서 가장 큰 규모입니다 .

2. AI 에이전트 시대, 왜 이제야 돈을 벌 수 있는 건가요?

최근 몇 년 동안 AI 기술은 정말 빠르게 발전했습니다. 예전에는 챗봇을 시험해보는 단계였지만, 이제는 매일 새로운 것이 등장하고 있습니다 .

하지만 많은 기업들이 AI에 투자한 만큼의 실질적인 수익을 아직 보지 못했다고 합니다 . 이제 그 상황이 'ai 에이전트' 덕분에 빠르게 바뀌고 있습니다. 예전의 AI 조수(Assistant)는 이제 사용자를 대신해 실제 작업을 수행하고 자동화할 수 있는 ai 에이전트로 진화하고 있습니다 . 이 ai 에이전트의 등장이 바로 AI 발전의 변곡점이라고 할 수 있습니다 . AI가 단순한 기술적 경이를 넘어, 우리에게 실질적인 가치를 제공하기 시작하는 순간인 것입니다 . AWS는 이러한 변화가 인터넷이나 클라우드만큼이나 비즈니스에 큰 영향을 줄 것이라고 보고 있습니다 .

미래에는 모든 회사와 모든 분야에 수십억 개의 ai 에이전트가 존재하게 될 것이라고 예측합니다 . 이미 ai 에이전트는 헬스케어의 발견을 가속화하고 있으며 , 고객 서비스를 개선하고 급여 처리 효율을 높이는 데도 사용되고 있습니다 . 어떤 경우에는 사람들의 업무 영향력을 10배까지 키워주어, 사람들이 더 많은 것을 창조할 시간을 만들어주고 있다고 합니다 . AWS는 이러한 에이전트 시대를 위해 인프라와 애플리케이션의 한계를 계속해서 넓혀가고 있습니다 .

3. 엔비디아 GPU는 AWS에서 가장 안정적인가요?

ai 에이전트를 작동시키려면 가장 중요하고 확장성 높은 ai 인프라가 필요합니다 . AWS는 이 분야에서 최고의 성능과 낮은 비용을 제공하고자 노력하고 있습니다 .

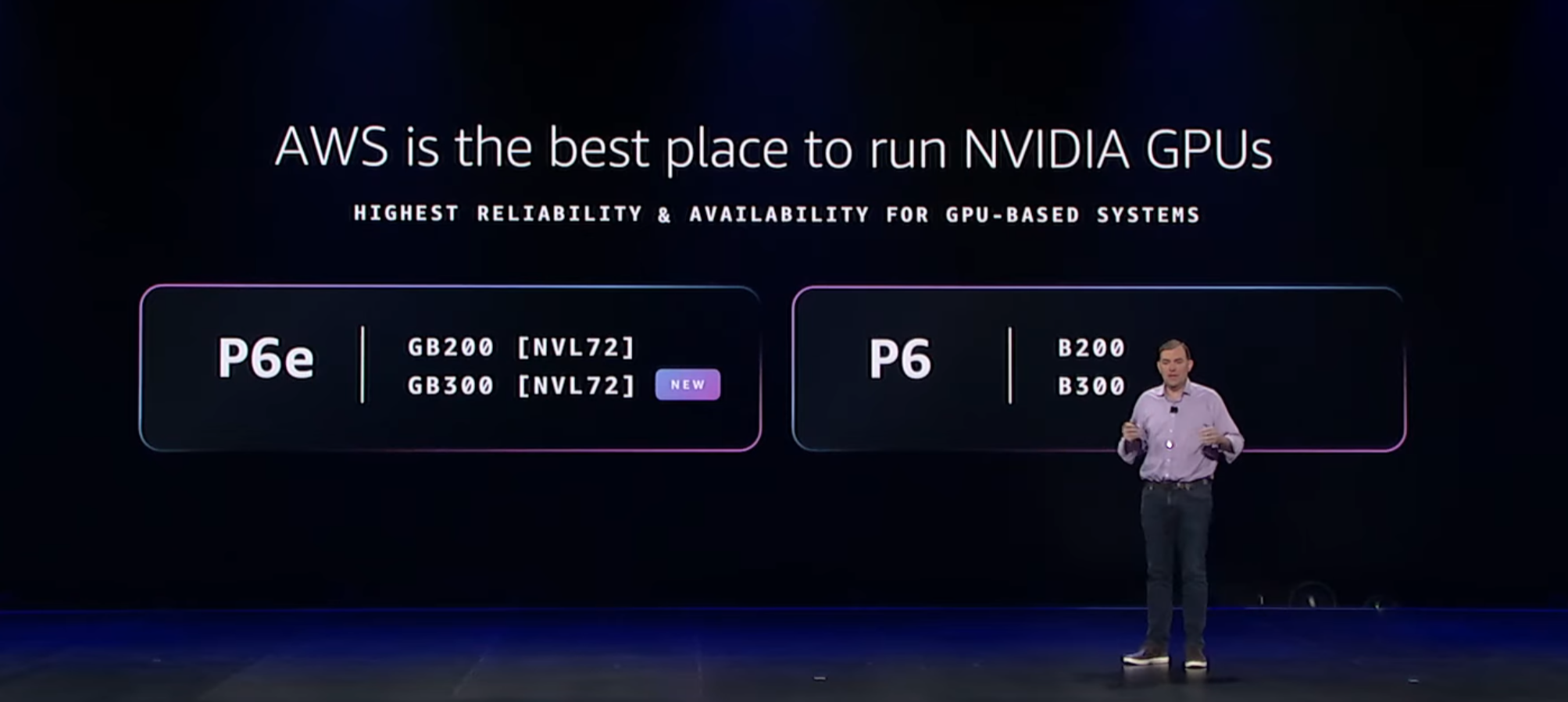

AWS는 엔비디아 GPU를 클라우드에서 가장 먼저 제공했습니다 . 엔비디아와 15년 이상 협력해왔기 때문에, GPU를 대규모로 운영하는 노하우가 엄청납니다 . 실제로 대규모 GPU 클러스터를 운영해 본 사람들은 AWS가 가장 안정적이라고 말할 것입니다 . AWS는 다른 곳에서는 흔히 발생하는 노드 오류를 더 잘 방지하고 최고의 안정성을 제공하고 있습니다 . AWS는 작은 문제 하나하나도 놓치지 않고 해결하려고 노력합니다 . 예를 들어, GPU 재부팅을 막기 위해 바이오스(BIOS)를 디버깅하는 사소한 부분까지도 신경 씁니다 . 모든 문제를 조사하고 근본 원인을 찾아서 엔비디아와 협력하며 개선합니다 .

이러한 노력 덕분에 AWS는 GPU 안정성 분야에서 업계를 선도하고 있습니다 . AWS는 엔비디아의 최신 칩을 탑재한 P6E GB200 울트라 서버와 새로운 p6e gb300 인스턴스를 출시했습니다 . 이 서버들은 이전 세대보다 20배 이상의 컴퓨팅 성능을 제공합니다 . 엔비디아 자체도 대규모 AI 클러스터 프로젝트를 AWS에서 운영하고 있습니다 . OpenAI 같은 회사도 ChatGPT 운영과 차세대 모델 훈련을 위해 AWS를 사용하고 있습니다 . 이는 AWS의 인프라와 안정성이 최고라는 것을 보여주는 증거라고 할 수 있습니다 .

4. AWS의 자체 제작 칩, '트레이니엄'의 성능은 어떤가요?

AWS는 고객에게 다양한 선택지를 제공하려고 자체 개발한 AI 프로세서도 만들고 있습니다 . 그중 하나가 바로 '트레이니엄(Trainium)' 칩입니다 .

트레이니엄은 ai 워크로드에 최고의 가격 대비 성능을 제공하도록 설계되었습니다 . 이름 때문에 AI 학습(Training)에만 좋다고 생각하실 수 있지만, 사실 트레이니엄 2는 추론(Inference)에도 현존하는 최고의 시스템입니다 . 고객들은 이미 트레이니엄을 사용하고 있을 수 있습니다. 현재 아마존 베드락(amazon bedrock)에서 실행되는 대부분의 추론 작업이 사실 트레이니엄으로 구동되고 있습니다 . 특히 앤트로픽(Anthropic)의 클로드(Claude) 최신 모델을 베드락에서 사용하면, 다른 주요 서비스 제공업체보다 최고의 응답 시간을 보여줍니다 . AWS는 이미 100만 개 이상의 트레이니엄 칩을 배포했습니다 . AWS는 이 칩을 자체적으로 설계하고 시스템 전체를 제어하기 때문에, 매우 빠르게 도입할 수 있었습니다 .

AWS는 여기서 멈추지 않고 있습니다. 트레이니엄 3 울트라 서버를 새로 발표했는데요 . 이는 AWS 클라우드 최초의 3나노미터 AI 칩을 포함하고 있습니다 . 트레이니엄 3는 대규모 AI 학습 및 추론에서 업계 최고의 가격 대비 성능을 제공합니다 . 트레이니엄 3 울트라 서버는 트레이니엄 2보다 컴퓨팅 성능은 4.4배, 메모리 대역폭은 3.9배 더 높습니다 . 또한, 전력당 처리할 수 있는 AI 토큰은 5배 더 많아 전력 효율이 매우 뛰어납니다 . AWS는 벌써 트레이니엄 4도 열심히 설계 중입니다. 트레이니엄 4는 트레이니엄 3보다 FP4 컴퓨팅 성능이 6배, 메모리 대역폭은 4배 더 좋아질 예정입니다 .

5. Amazon Bedrock은 생성형 AI 앱 개발을 어떻게 돕나요?

AI 애플리케이션의 성공을 위해서는 강력한 인프라뿐만 아니라 안전하고 확장 가능한 추론 플랫폼이 필요합니다 . 아마존 베드락(amazon bedrock)이 바로 그 역할을 수행합니다 .

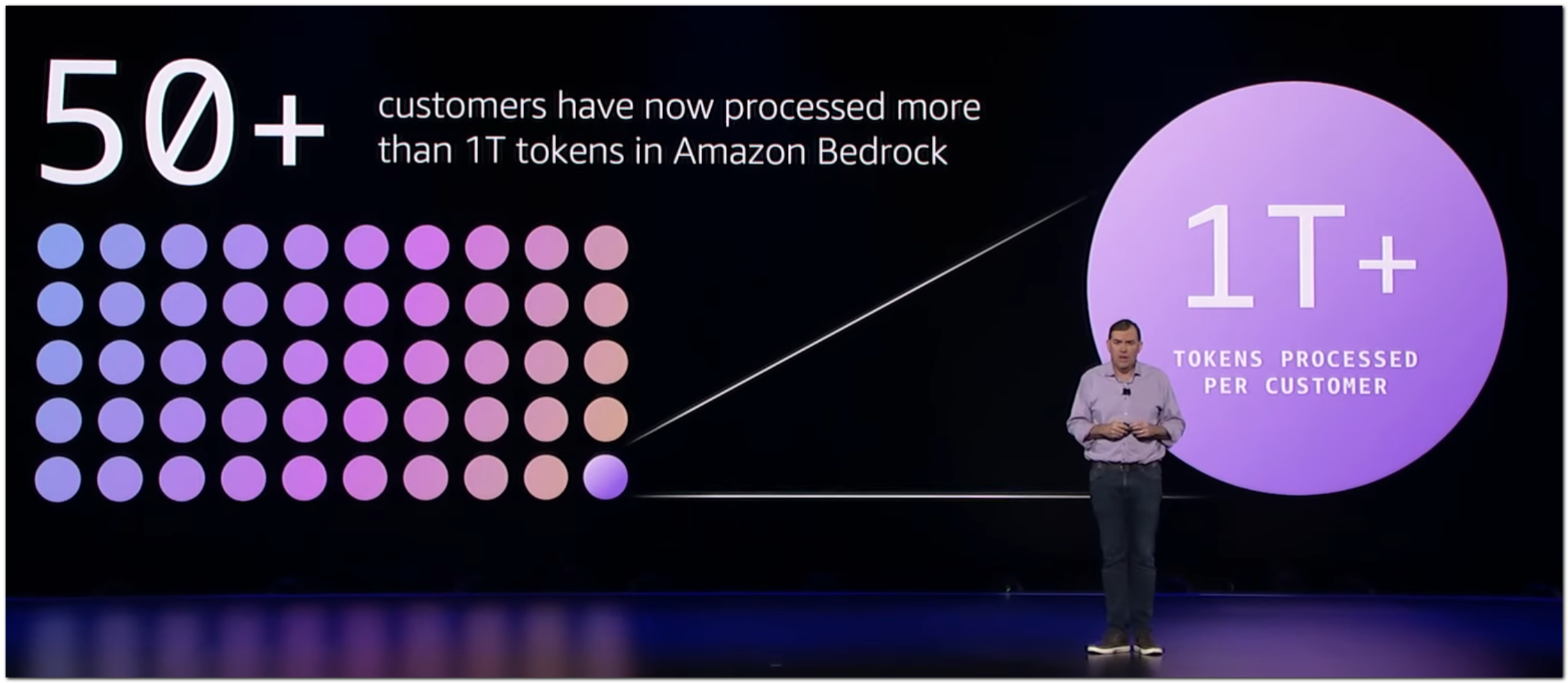

베드락은 생성형 ai 애플리케이션을 빠르게 프로토타입에서 상용 서비스로 전환할 수 있도록 도와주는 플랫폼입니다 . 베드락을 사용하면 다양한 최신 모델을 선택할 수 있으며 , 사용 목적에 맞게 모델을 커스터마이징하고, 데이터를 통합하며, 안전 장치(Guardrail)를 추가할 수 있습니다 . 전 세계 모든 규모와 산업의 기업들이 베드락을 사용하고 있습니다. BMW, GoDaddy, Strava 같은 회사들이 고객입니다 . 베드락을 사용하는 고객 수는 작년 대비 두 배 이상 증가했습니다 . 실제로 베드락을 통해 1조 개 이상의 토큰을 처리한 고객사가 50곳이 넘는다는 것은 정말 놀라운 규모와 성과입니다 .

AWS는 하나의 모델이 모든 것을 지배할 것이라고 생각하지 않습니다. 따라서 베드락에서는 모델 선택의 폭이 매우 넓습니다 . 오픈 소스 모델부터 독점 모델까지, 일반 목적 모델이나 특수 모델까지 다양하게 제공됩니다 . AWS는 지난 한 해 동안 베드락에서 제공하는 모델 수를 거의 두 배로 늘렸습니다 . 구글의 Gemma, Minimax M2, 엔비디아의 Neotron 같은 새로운 오픈 소스 모델들도 계속 추가하고 있습니다 . 미스트랄 AI(Mistral AI)의 Mistral Large와 Ministrol 3 같은 새로운 모델도 베드락에서 바로 사용할 수 있게 되었습니다 .

6. AWS가 만든 파운데이션 모델, 'Nova'는 얼마나 똑똑한가요?

AWS는 써드파티 모델 외에도 아마존의 자체 파운데이션 모델인 'Amazon Nova'를 제공하고 있습니다 . 노바는 다양한 워크로드에 최고의 가격 대비 성능을 제공합니다 .

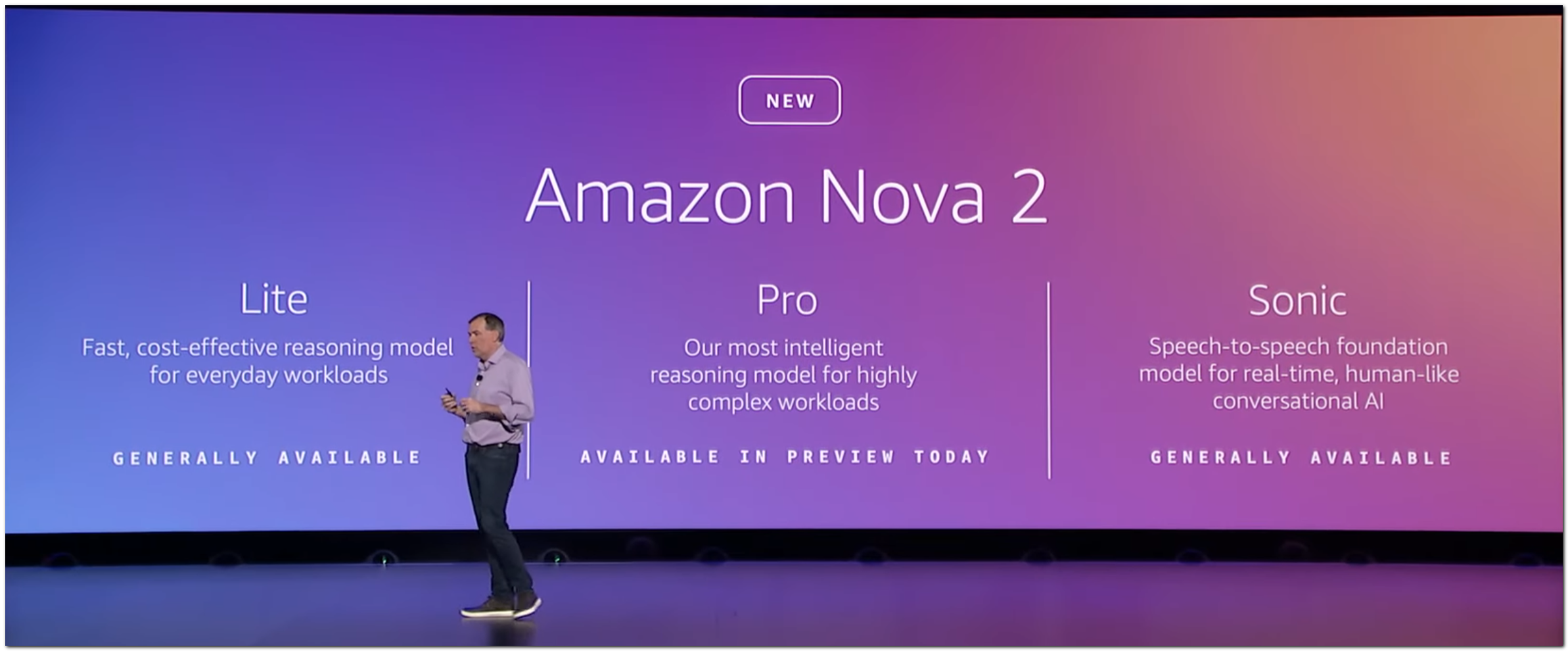

지난 한 해 동안 노바 제품군은 더 많은 사용 사례를 지원하도록 확장되었습니다 . 예를 들어, 음성-음성 사용 사례를 지원하는 Amazon Sonic도 출시되었습니다 . 노바는 현재 수만 명의 고객이 사용하고 있으며, Denu, Infosys, Blue Origin 같은 다양한 기업이 고객입니다 . 이제 AWS는 Nova 2라는 새로운 세대의 모델을 발표했습니다 . Nova 2는 비용 효율적이고 지능적인 모델입니다 . Nova 2 Light는 빠르고 비용 효율적인 추론 모델이며, Nova 2 Pro는 복잡한 워크로드를 위한 가장 지능적인 추론 모델입니다 .

Nova 2 Light는 명령어 따르기, 도구 호출, 코드 생성, 정보 추출 같은 작업에서 매우 뛰어납니다 . 이는 경쟁 모델인 Claude Haiku 45, GPT5 Mini, Gemini Flash 2.5와 비교해도 우수한 성능을 보여줍니다 . Nova 2 Pro는 매우 복잡한 워크로드에 적합한 모델입니다 . 특히 에이전트가 뛰어난 능력을 발휘해야 하는 영역, 예를 들어 명령어 따르기나 에이전트의 도구 사용 기술에서 Nova 2 Pro는 GPT 5.1, Gemini 3 Pro보다 더 나은 결과를 제공합니다 . 게다가 새로운 Nova 2 AMI는 텍스트, 이미지, 비디오, 오디오를 모두 이해하고 텍스트와 이미지 생성을 지원하는 업계 최초의 통합 멀티모달 추론 모델입니다 .

7. 나의 독점 데이터를 모델에 어떻게 깊숙이 학습시킬 수 있나요?

AI 모델이 회사 고유의 데이터를 깊이 이해하는 것이 기업 가치를 창출하는 핵심입니다 . 회사의 데이터는 경쟁자와 차별화되는 요소입니다 .

하지만 외부 모델은 기본적으로 회사의 비즈니스에 대해 알지 못합니다 . 모델이 독점 데이터에 접근하게 하는 일반적인 방법은 RAG(검색 증강 생성) 같은 기술을 사용하는 것입니다 . 하지만 고객들은 모델이 데이터와 전문 지식을 '정말' 이해하기를 원합니다 . 기존에는 완전히 새로운 모델을 만들거나 오픈 소스 모델을 미세 조정(Fine-tuning)하는 방법이 있었습니다 . 하지만 이 방법들은 비용이 많이 들거나 새로운 도메인 지식을 가르치는 데 한계가 있었습니다 .

AWS는 이 문제를 해결하기 위해 'Amazon Nova Forge'를 발표했습니다 . 노바 포지(Nova Forge)는 '오픈 트레이닝 모델(Open Training Models)' 개념을 도입한 새로운 서비스입니다 . 이 서비스를 통해 고객은 Nova 모델의 학습 체크포인트에 독점적으로 접근할 수 있습니다 . 고객은 아마존이 선별한 학습 데이터와 고객의 자체 데이터를 모델 학습의 모든 단계에서 혼합할 수 있습니다 . 이렇게 하면 모델이 핵심 정보를 잊지 않으면서 고객의 정보를 깊이 이해하는 맞춤형 모델을 만들 수 있습니다 . 이 결과로 만들어진 모델을 '노벨라(novellas)'라고 부르며, 베드락에서 쉽게 실행할 수 있습니다 . 예를 들어, Reddit은 이 기술을 사용하여 콘텐츠 검열 모델의 정확도와 비용 효율성 목표를 처음으로 달성했습니다 .

8. AWS Agent Core는 에이전트의 안전과 통제를 어떻게 보장하나요?

ai 에이전트가 강력한 이유는 자율적으로 행동할 수 있다는 점입니다 . 하지만 이 자율성 때문에 에이전트가 통제 범위를 벗어나지 않도록 하는 것이 중요합니다 .

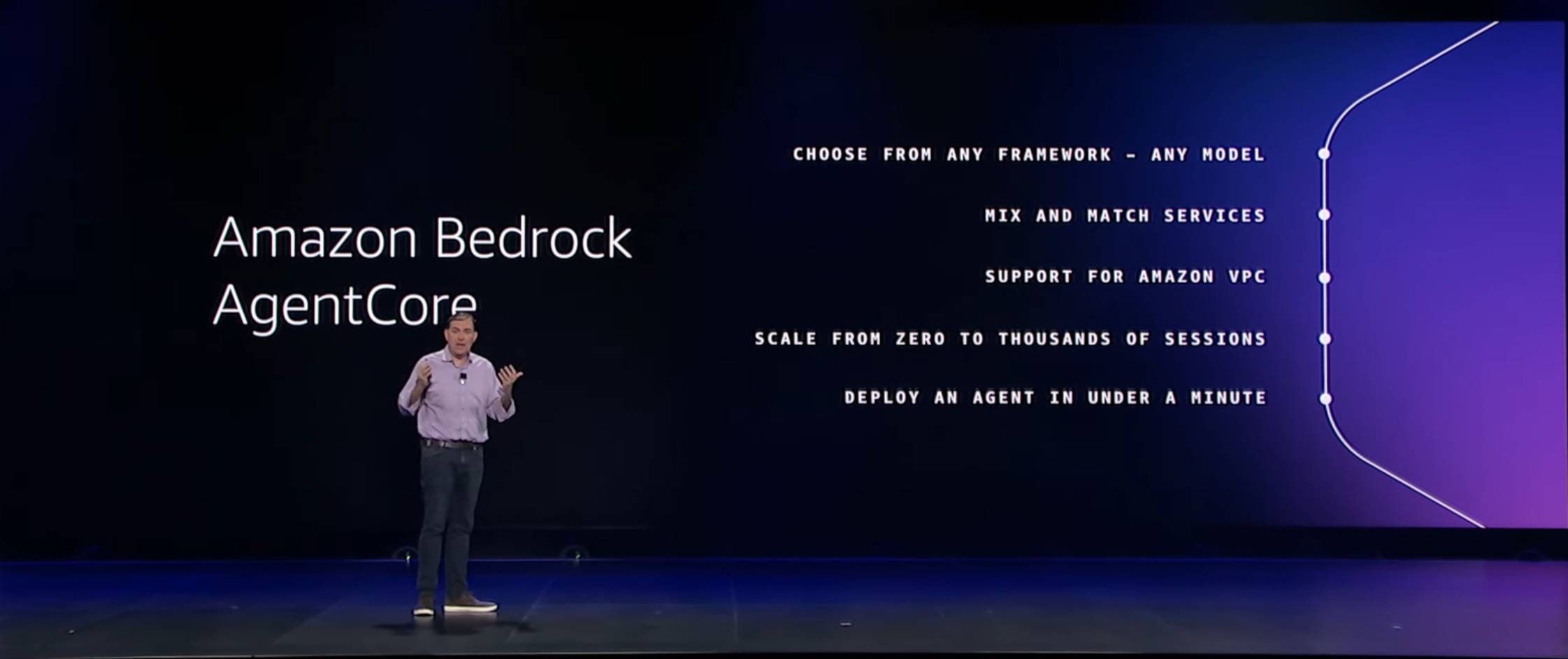

AWS는 에이전트를 안전하게 구축, 배포, 운영할 수 있는 가장 진보된 플랫폼인 amazon bedrock Agent Core를 출시했습니다 . 에이전트 코어는 보안 서버리스 런타임을 제공하여 에이전트가 완전히 격리된 환경에서 실행되도록 보장합니다 . 또한 에이전트가 맥락을 유지하고 학습하도록 돕는 메모리 기능도 제공합니다 . 에이전트 코어의 주요 기능 중 하나는 '정책(Policy)'입니다 . 정책은 에이전트가 기업의 도구와 데이터에 어떻게 상호작용하는지 실시간으로 통제할 수 있게 해줍니다 . 예를 들어, 환불 금액이 1,000달러를 초과하면 환불을 차단하도록 정책을 설정할 수 있습니다 . 에이전트 코어는 모든 에이전트의 행동을 도구에 접근하기 전에 이 정책과 비교하여 확인합니다 .

또한, AWS는 에이전트의 성능과 품질을 지속적으로 점검하기 위한 'Agent Core Evaluations'도 발표했습니다 . 이 서비스는 에이전트의 실제 행동을 기반으로 품질을 검사합니다. 정확성, 유용성, 유해성 등 13가지 사전 구축된 평가 도구를 제공합니다 . 이제 개발자는 복잡한 데이터 파이프라인이나 전문 인력 없이도 에이전트의 품질을 쉽게 평가하고 개선할 수 있게 되었습니다 . 이는 에이전트가 예상치 못한 행동을 하지 않도록 지속적으로 감시하는 역할을 합니다 .

9. 개발자들을 위한 혁신적인 AI 에이전트는 무엇인가요?

AWS는 개발자들이 겪는 가장 큰 문제 중 하나인 '기술 부채(Tech Debt)' 해결을 위해 AI를 활용하고 있습니다 . 기술 부채는 레거시 시스템을 유지하는 데 엄청난 비용을 발생시킵니다 .

AWS Transform은 고객이 메인프레임이나 Windows .NET 같은 레거시 플랫폼에서 벗어나도록 돕고 있습니다 . 실제로 고객들은 이미 10억 줄이 넘는 메인프레임 코드를 분석하며 클라우드로 이전하고 있습니다 . 최근에는 AWS Transform Custom을 출시하여, 어떤 코드, API, 프레임워크, 언어라도 맞춤형 코드 변환 에이전트를 만들어 현대화할 수 있게 되었습니다 .

하지만 더 중요한 것은 개발 경험 자체를 혁신하는 것입니다 . AWS는 개발자들이 AI 코딩의 속도를 활용하면서도 더 체계적으로 작업할 수 있도록 'Kiro'라는 에이전트형 개발 환경을 출시했습니다 . Kiro는 개발자가 원하는 목표를 구체적인 '사양(Spec)'으로 바꾸고, 이를 통해 작동하는 코드를 만들어냅니다 . 이미 수십만 명의 개발자가 Kiro를 사용하고 있으며, 단 몇 달 만에 과거 10년치보다 많은 코드를 배포하는 성과를 보였습니다 .

AWS는 이제 '프론티어 에이전트(Frontier Agents)'라는 새로운 종류의 에이전트를 선보이고 있습니다 . 이 에이전트들은 자율적이고, 대규모로 확장 가능하며, 인간의 개입 없이 장기간 목표를 추구할 수 있습니다 . 첫 번째 프론티어 에이전트는 ' Kiro 자율 에이전트( Kiro Autonomous Agent)'입니다 . 이 에이전트는 복잡한 작업을 할당받으면 스스로 계획을 세우고 작업을 수행합니다 . 예를 들어, 15개의 마이크로서비스에 걸쳐 라이브러리를 업데이트해야 할 때, Kiro 자율 에이전트는 모든 관련 저장소를 식별하고, 코드를 업데이트하며, 전체 테스트를 실행한 후, 준비된 풀 리퀘스트 15개를 열어줍니다 . 이 모든 것이 개발자가 다른 일에 집중하는 동안 백그라운드에서 진행됩니다 .

10. AWS는 소프트웨어 개발의 모든 과정을 어떻게 자동화하나요?

소프트웨어 개발 과정에서 코드를 빨리 작성하는 것만으로는 부족합니다. 개발 주기의 모든 단계가 가속화되어야 병목 현상을 막을 수 있습니다 . AWS는 이 전체 프로세스를 혁신하기 위한 새로운 프론티어 에이전트들을 출시했습니다 .

첫째는 'AWS 보안 에이전트(AWS Security Agent)'입니다 . 이 에이전트는 개발 초기에 보안 전문 지식을 통합하여 애플리케이션을 안전하게 만들도록 돕습니다 . 디자인 문서와 코드를 선제적으로 검토하고 취약점을 스캔합니다 . 심지어 침투 테스트(Penetration Testing)를 주문형 서비스로 바꿔서, 지속적으로 애플리케이션의 보안 상태를 검증할 수 있게 해줍니다 . 보안 에이전트는 문제 발생 시 수정 코드를 제안해주기도 합니다 .

둘째는 'AWS DevOps 에이전트(AWS DevOps Agent)'입니다 . 이 에이전트는 인시던트(장애)를 해결하고 사전에 방지하여 시스템의 안정성과 성능을 지속적으로 개선합니다 . 이 에이전트는 기존의 모니터링 솔루션, 런북, 코드 저장소 등 다양한 소스의 데이터를 통합하여 근본 원인을 찾아냅니다 . 예를 들어, 장애가 발생하면 온콜 엔지니어가 확인하기도 전에 에이전트가 즉시 대응하여 문제를 진단합니다 . 문제 해결을 위한 변경 사항을 제안하고, 심지어 미래에 같은 문제가 발생하지 않도록 CI/CD 보호 장치를 추천해주기도 합니다 . 이 세 가지 프론티어 에이전트( Kiro 자율 에이전트, 보안 에이전트, DevOps 에이전트)가 함께 작동하면서 소프트웨어를 구축하고, 보호하고, 운영하는 방식을 완전히 바꿀 것입니다 .

11. AWS가 10분 만에 발표한 25가지 핵심 서비스는 무엇인가요?

AWS 키노트에서는 ai 에이전트 외에도 컴퓨팅, 스토리지, 데이터베이스 등 핵심 서비스에 대한 수많은 업데이트가 발표되었습니다 . aws ceo는 이 모든 것을 10분 안에 발표하는 놀라운 기록을 세웠습니다 .

컴퓨팅 분야:

-

메모리 집약적인 애플리케이션을 위한 차세대 X 패밀리 대용량 메모리 인스턴스가 출시되었습니다 .

-

C8A 인스턴스는 최신 AMD EPYC 프로세서를 기반으로 30% 더 높은 성능을 제공합니다 .

-

가장 빠른 CPU 클럭 주파수를 가진 M8AN 인스턴스도 나왔는데, 이는 멀티플레이어 게임이나 고빈도 트레이딩에 이상적입니다 .

-

Mac 기반 인스턴스도 M3 Ultra Mac, M4 Max Mac 인스턴스로 업데이트되었습니다 .

-

Lambda 함수에 '기다리는' 시간을 프로그래밍할 수 있는 Lambda Durable Functions이 도입되었습니다 .

스토리지 분야:

-

S3의 최대 객체 크기가 기존 5테라바이트에서 10배 커진 50테라바이트로 증가했습니다 .

-

배치 작업 성능이 10배 빨라졌고, S3 테이블용 지능형 계층화 기능이 추가되어 저장 비용을 최대 80% 절감할 수 있습니다 .

-

벡터 임베딩을 위한 S3 Express One Zone이 정식 출시되었는데, 이는 비용을 90%까지 줄여줍니다 .

-

Amazon OpenSearch의 벡터 인덱싱에 GPU 가속 기능이 추가되어 10배 더 빠르게 데이터를 인덱싱할 수 있습니다 .

데이터베이스 및 보안 분야:

-

RDS for SQL Server와 Oracle의 저장 용량이 64TB에서 256TB로 4배 증가했습니다 .

-

SQL Server 인스턴스에 활성화되는 vCPU 수를 지정하여 라이선스 비용을 줄일 수 있게 되었습니다 .

-

GuardDuty의 위협 탐지 기능이 ECS까지 확장되었고, Security Hub도 실시간 위험 분석 기능 등을 포함해 일반에 공개되었습니다 .

-

가장 중요한 소식 중 하나는 모든 데이터베이스 서비스 사용량에 대해 최대 35%까지 절약할 수 있는 '데이터베이스 절약형 플랜(Database Savings Plans)'이 출시된 것입니다 .

12. 향후 기대

이번 re:Invent 키노트에서 가장 주목해야 할 부분은 ai 에이전트의 비즈니스 전면 확산입니다. AWS는 Kiro 자율 에이전트, 보안 에이전트, DevOps 에이전트와 같은 프론티어 에이전트들을 통해 AI가 단순한 코딩 보조 도구를 넘어, 소프트웨어 개발 및 운영의 전 주기를 자율적으로 처리하고 비즈니스 프로세스를 최적화하는 단계로 진입했음을 보여주었습니다. 이는 모든 기업이 수십억 개의 ai 에이전트를 통해 혁신을 가속화하고, 새로운 차원의 효율성과 생산성을 확보할 수 있다는 기대를 높여줍니다.

또한, 자체 제작 칩인 트레이니엄(Trainium) 시리즈의 진화는 인프라 비용 효율화의 미래를 제시합니다. 트레이니엄 3 울트라 서버와 곧 출시될 트레이니엄 4는 엔비디아 GPU와 함께 고객에게 최고의 성능을 제공하면서도, 특히 가격 대비 성능 및 전력 효율성 측면에서 압도적인 이점을 제공할 것으로 기대됩니다. 이는 AI 학습 및 추론 비용을 획기적으로 낮추어, AI 혁신의 문턱을 더욱 낮추는 핵심 동력이 될 것입니다.

13. 전체 평

aws re:invent 2025 CEO 키노트는 단순한 기술 사양의 발표를 넘어, AI가 실질적인 비즈니스 가치를 창출하는 시대의 개막을 선언한 전환점으로 평가됩니다. AWS는 압도적인 인프라 확장성(1,320억 달러 규모의 성장, 전 세계 최대 데이터 센터 용량)을 기반으로, 가장 안정적인 GPU 클러스터 환경과 자체 개발한 고효율 트레이니엄 칩을 통해 AI 혁신의 밑바탕을 다졌습니다.

특히, amazon bedrock 플랫폼과 Nova Forge를 통한 독점 데이터 학습 솔루션은 기업이 AI 모델을 단순히 사용하는 것을 넘어, 자사의 핵심 경쟁력을 강화하는 맞춤형 AI를 구축할 수 있게 합니다. 에이전트 코어(Agent Core)의 통제 및 평가 기능은 자율적인 ai 에이전트의 안전한 도입을 보장함으로써, 기업들이 주저 없이 AI 자동화에 투자할 수 있는 환경을 마련해 주었습니다. 이번 키노트는 AI를 '실험'하는 단계를 넘어 '수익 창출' 단계로 끌어올린, 매우 실용적이고 영향력 있는 로드맵을 제시한 것으로 요약할 수 있습니다.